增长黑客不谈A/B测试是耻辱。

互联网世界日新月异,伴随流量红利时代的结束,对互联网产品快速迭代的要求也大大提升。增长黑客的核心在于,能够利用小范围的数据驱动快速迭代、快速验证,再大规模地运用。快速验证,如何验证?主要方法就是A/B测试。

在去年的活动中,吆喝科技副总裁柏利锋Eric做了精彩分享。今年我们又请他来到旅讯在线讲堂,更加详细地说说如何通过A/B测试,提升用户体验,持续优化增长?(在线讲堂将于5月31日,下周四14:30-15:20举行。点击此处可立即报名。)

我们已经收到了一系列的报名留言,大家纷纷针对业务中如何运用A/B测试提出了自己的思考、疑惑和难点。Eric看到之后,精选和整理了10个有代表性的实战问题进行回复。

快问快答5道题

(1)做A/B测试,如何一开始把测试环境放准确?很多测试由于之前设置的环境问题,导致结果只是朝着设置人预想的结果走,并无实际意义。

对A/B测试来说,试验方案的规划是很重要的。从最开始就要避免试验方案设计的问题,比如优化指标设置不合理、没有实际对比价值,多个版本的试验方案试验结果对业务的提升无意义,试验场景不合理等等。一般来说,大的原则是:采样分流具有代表性、版本设计合理具有试验意义,对业务优化有帮助、优化指标准确可衡量。

(2)除了随机分组,如何排除干扰因素,保证两个组的倾向性一致?

应该是尽可能的多的获取用户维度信息,针对这些用户维度,进行科学的分桶加随机分组策略,才能够最大限度的保证分组的一致性

(3)A/B 测试如何快速实施部署,引入最小的开发量?

如果想快速实施部署,引入最小的开发量,最推荐的做法就是引入第三方的A/B测试服务,他们针对各种场景都做过接入流程优化,确保在最小的开发量的基础上快速的实现A/B测试。

(4)如何更快速产出A/B 测试的效果数据?

进入A/B测试样本量与试验达到效果的速度是正比关系,所以放大进入A/B测试的流量是最为有效的办法。

(5)如何管理大批量的自动化测试和迭代?

首先,如果是真正的自动化A/B 测试,那么相应的,一定会有一套管理的工具来配合,比如试验监控系统,结果反馈系统,权限管理系统等。

其次,目前市面上并没有完全自动化的A/B测试工具。A/B 测试的需求分析,试验的创建、试验结果分析等核心步骤依然需要员工来参与。

那么在这种情况下,大批量的试验管理主要涉及到平台权限管理、试验需求管理、试验结果分析与共享等,当然,这些管理都是基于一个能够承载如此高密度的试验的平台的基础之上。

答疑详解5道题

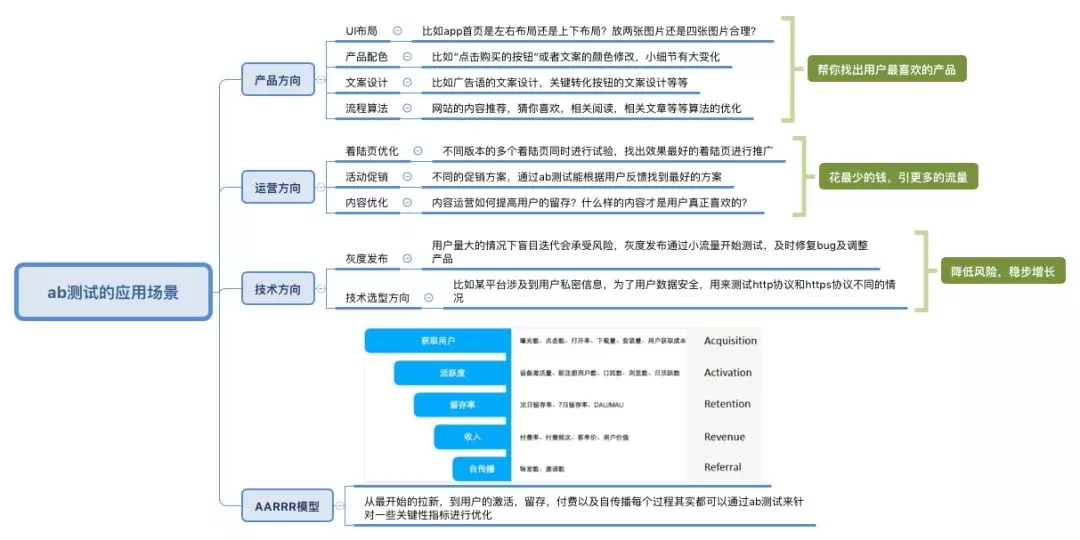

(1)A/B测试的使用场景有哪些?

对于展示类广告和SEM优化,A/B测试主要应用在素材和着陆页的优化中。针对素材,投放什么风格或类型的图片,文案如何搭配,banner展示的样式和位置等,不同元素以不同形式凑成不同的组合方案,到底哪一种组合会带来更好的转化效果,可以借助A/B来验证,并在不断测试的过程中找到影响转化效果最大的元素进行持续优化。同理,对于着陆页也是如此,针对不同渠道,页面UI设计、宣导的价值主张和活动创意等也可以利用A/B 测试来优化。

比如某个产品页面是让学生更好的了解课程价值从而带来更多立即购买的转化。通过数据分析或者热图分析,发现看了课程大纲内容的用户更容易购买该课程。在这个产品页面中,课程大纲的内容是在整个页面偏下的位置,于是可以提出假设,如果将课程大纲这个版块放置在价格之前是否能带来更多的购买转化?基于这个假设,用A/B测试来验证假设是否成立。就是通过这种方式来不断优化产品页面的转化效果。

(2)问:如何判断一个试验是否满足A/ B测试的要求?

有以下几个关键点:

i. 试验样本分配是否科学,能否保证特征一致性。从而确保试验结果的可信度。Adhoc系统采用,先聚类分群,再随机分配的智能分流算法,保证了试验样本特征的一致性。

ii. 原始版本与试验版本的并行性,不同的版本要保证同一时间段,同时在线上跑。从而保证了试验样本在时间维度上的一致性。

iii. 分析结果的科学性,A/ B测试不是简单地记录求平均值,转化率。得出的结论要基于统计学原理公式计算得出。Adhoc系统后台的统计相关算法会给出置信区间、统计功效等维度信息,辅助决策者做出科学、准确、可信的决定。

(3)问:A/B测试适合的操作场景,测试过程中的注意事项以及结果分析的常用维度能不能解释一下?

A/B测试,适用于营销LandingPage(着陆页)的优化,产品新功能迭代改版,内容运营标题配图优化,页面布局排版优化,付款页面CTA样式优化,Feed流推荐算法优化,转化路径排序优化等等多种场景。

A/B测试过程中有以下几点需要特别注意:

i. 试验设计符合业务真实场景需求。不要为了试验而试验,试验的最终目的是要为业务带来提升。

ii. 科学合理的指标设定,通常一个试验只有一个核心指标,另外有若干辅助指标帮助做决策。

iii. 试验流量分配问题,默认推荐原始版本与试验版本均分试验流量。除非有特殊需求,否则不推荐流量分配区别对待。并且要注意,流量分配比例不要频繁调整,会影响样本数据采集的准确性。

至于维度分指标和用户维度两个方面来解答:

i. 优化指标,通常有UV、PV、按钮点击数、图片点击数、停留时长、页面转化率、留存率等等。根据不同业务场景需求,还可以自定义多种指标。

ii. 用户维度方面,最常用的维度包括新老用户,地域,性别,年龄等,也是各行业通用的用户维度。

(4)在设计A/B测试计划的时候会着重考虑哪些方面的因素来保障测试结果的效度?例如,如何排除在测试中价格波动造成的不可预测的转化率差异?

这个问题主要涉及到A/B测试的分流问题。

A/B测试的分流原则,就是在保证除了A/B两种方案不同以外,其他的环境因素都相同。如价格波动,A/B两种方案都会经历价格波动,也就排除了很大一部分价格波动的干扰。

另外,适当的延长A/B测试时间,可以更加有效的排除价格急剧变动这样突发因素的影响。

如有必要,需要将价格波动这个因素单独拿出来进行A/B测试,测试出价格对转化率的影响曲线。

(5)如何分析反馈数据?

基础数据分析:

试验开始之后的短时间内(几个小时或者1天),我们应该通过实时观察「试验概况」与「指标详情」页面,来检查试验数据是否表现正常,也就是检查是否有程序错误。如果包括原始版本在内的任一版本没有数据显示或者和正常数据相比有很大的、异常的差异,说明试验可能在集成环节出现问题,或者存在程序错误。这时需要停止试验,重新检查调试。

若短时间内的数据正常,试验应继续运行至预定的结束时间,然后就可以分析和解读试验数据,进而做出决策了。一般而言,这个试验时段大概是至少1-2个周,这样才能得出较为准确的结果。我们主要通过某个指标的试验版本(均值)变化值以及置信区间来判断,在这个指标上,试验版本是否比对照版本(原始版本)表现得更好。如果置信区间同为正或同为负,说明试验结果是统计显著的。如果置信区间为一正一负,说明试验结果是非统计显著的。

进阶数据分析:

统计显著说明当前的样本容量条件下已经检测出试验版本和对照版本的差异。如果这个差异(变化)是正的,是不是说我们就可以下结论试验版本比对照版本好,应该发布该试验版本了呢?

试验版本的结果只有兼备统计显著和效果显著两个特征,该版本才是可用的,值得发布的。这里,我们需要引入一个“最小重要变化”的概念来帮助我们判断和决策。

非统计显著的试验怎么办:

如果试验已经充分进行(足够的时间,足够的样本容量),说明样本的方差较大,试验难以检测出版本差异,这种情况下我们可以重新设计和进行新的试验,改进统计功效;

如果试验进行的时间不够(如不到 7 天),或者样本容量可能不够(根据 App 用户数大致判断),可以继续进行试验到足够时间和用户数,随着试验的进行,样本方差可能会减少,置信区间会进一步收敛。

文章太长,内容太多?先收藏着慢慢看。

5月31日(周四)下午,来听听吆喝科技副总裁柏利锋在线上讲堂的演绎,到时候还有不懂怎么办?我们有线上互动环节,到时候大家还可以在线提问、互动。

点击此处,立即报名。

个人资料

个人资料  退出登录

退出登录

评论

未登录